Technologie und Entwicklungsansatz der Advanced Conversational AI

Wie sich die Automobilindustrie durch Elektrofahrzeuge neu definiert, erfordert auch die Conversational AI einen Wandel. Neue Plattformen, Prozesse und Tools, basierend auf generativer KI, sind essenziell, um diese Technologie weiterzuentwickeln und ihr volles Potenzial auszuschöpfen.

Die Generative KI kann den Kundenservice mit Ihrer Technologie nachhaltig transformieren.

Dabei gibt es aber zwei grundsätzliche Herausforderungen:

1. Aktuell verfügbare Conversational-AI-Tools ermöglichen nur einfache Anwendungen mit Large Language Models (LLMs) und sind weder effizient in der Nutzung der LLM-Fähigkeiten noch kostenoptimiert für den produktiven Einsatz

2. Bei rein auf Generativer KI basierenden Dialoganwendungen sind die zur Laufzeit getroffenen Entscheidungen nicht mehr nachvollziehbar und Halluzinationen gefährden den Einsatz. Die neue EU-KI-Verordnung gibt dabei jedoch einen Rahmen vor, der einen sicheren und transparenten Einsatz von KI-Systemen garantieren soll!

Mit über 20 Jahren Erfahrung in der Entwicklung hochkomplexer Conversational AI-Lösungen haben wir eine neue Generation von Conversational AI-Plattformen geschaffen. SemanticEdge nutzt die Vorteile von LLMs, um die Dialogintelligenz und Entwicklungsgeschwindigkeit von LLM-basierten Conversational AI-Lösungen vollständig auszuschöpfen. Gleichzeitig minimieren oder eliminieren wir potenzielle Nachteile von LLMs, um optimale Ergebnisse zu gewährleisten.

Sie haben Fragen?

Bitte melden Sie sich mit Ihren Anliegen per E-Mail an info@semanticedge.de oder unter +49 30 3450770

Differenzierung SemanticEdge – Ansätze Generative KI und Vorteile

Generative KI Ansatz- Task optimierte LLM-Nutzung

- Umfangreiche Knowledge Bases zum Finetuning

Vorteile:

- Minimierung der Halluzinationsrisiken und Kosten

- Transparente KI-Entscheidungen

- Optimierung von Reaktions-geschwindigkeit und Sicherheit

Dialogentwicklung- Automatisch generierte Dialoge

- Konfigurierbare Dialogtemplates

Vorteil: Deutlich schnellere Entwicklung von Dialogmodulen und Branchenlösungen

Time-to-Market- Konfigurierbare, ready-to-deploy feingeschliffene Branchenlösungen und Dialogmodule

Vorteil: Livegang in Wochen und nicht Monaten mit jahrelangem Feinschliff

Dialogqualität-/Intelligenz- Dynamische, hochgradig personalisierte Dialoge

Vorteile:

- Höhere Kundenzufriedenheit

- Höhere Automationsgrade

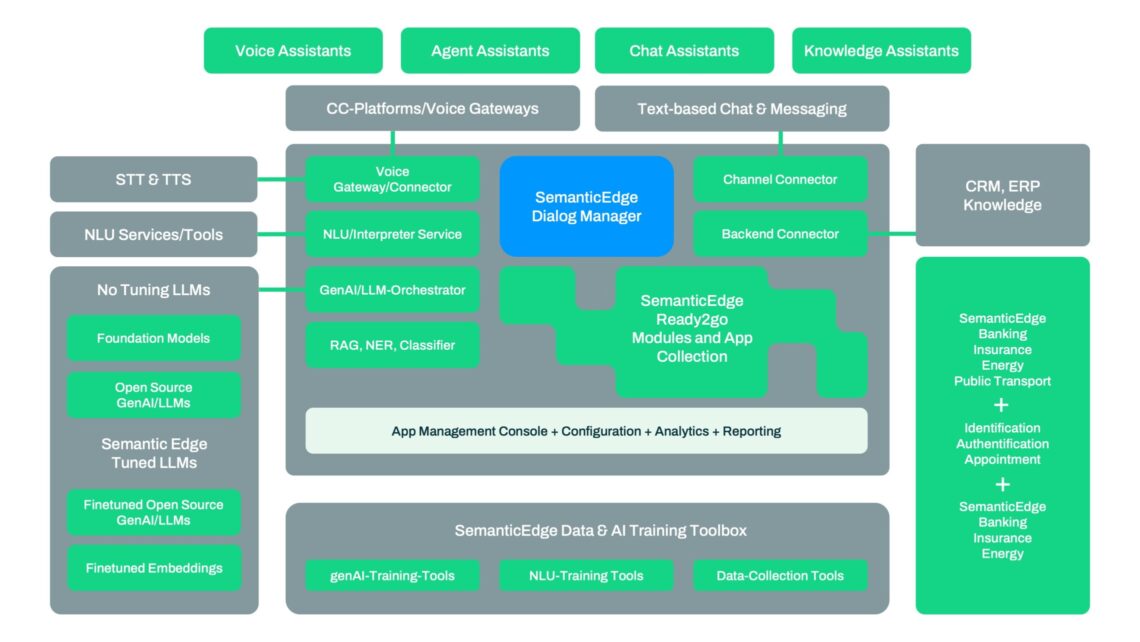

SemanticEdge Architektur KI-Assistenten mit Generativer KI

Ready-to-use KI-Assistenten und Knowledge Bases: Ein breites Spektrum Branchen-spezifischer Dialogmodule und Knowledge Bases und viele auch Branchen-unabhängige, im Produktivbetrieb getunte Dialogmodule ermöglichen einen schnellen Livegang und hohe Automationsgrade

Automatische Dialoggenerierung: Während die Dialogentwicklung in den Entwicklungsumgebungen anderer Anbieter noch auf starren Flußdiagrammen beruht, können mit der SemanticEdge Conversational AI-Plattform Dialoge genAI-basiert auch automatisch generiert werden. Das geht schneller und kostengünstiger und die Ausdrucksstärke lässt sich deutlich steigern

Task-orientierte LLM-Orchestration: Die LLM-Orchestrator-Komponente bindet dafür in einer Applikation unterschiedliche LLMs task-orientiert ein (Closed-source Modelle wie GPT oder Gemini, aber auch Open-Source Modelle). Sie kann mit den Knowledge Bases feingetunte LLMs auch on-prem einsetzen. Das reduziert die LLM-Kosten, garantiert eine volle Transparenz der KI-Entscheidungen und minimiert die Halluzinationsrisiken

GenAI Toolpipeline zur Aufbereitung der Daten: Zur Erstellung und dem Finetuning der jeweiligen Branchen-Datenpools, bzw. genAI Modelle bietet die SemanticEdge Conversational AI-Plattform entsprechende Tools und Pipelines, um z.B. massenhaft Kundenäußerungen aufzubereiten und für ein KI-System zur Verfügung zu stellen oder die LLM-Performance zu vergleichen. Die Qualität der Daten und die Finetuning-Möglichkeiten sind entscheidend für den Erfolg der Lösung

Weitreichende Konfiguration zur Laufzeit: Die mandantenfähigen KI-Assistenten sind über die Management Console hochgradig konfigurierbar. Der Kundenservice und die Fachbereiche können ohne Dialogdesign-Erfahrung Rollen- und Rechte-gesteuert weitreichende Applikationsänderungen zur Laufzeit vornehmen und erhalten detaillierte Einsichten in die Performance. Die MC erlaubt auch mit generativer KI tiefe Einblicke in die Dialogverläufe, um die gewünschte Sicherheit und Transparenz zu gewährleisten

Omnichannel Integration:

Die Integration der Conversational AI-Plattform in die bestehende Omnichannel CC-Infrastruktur, ggf. vorhandene NLUs und die Frondends und Backends geschieht jeweils über den Telephony/CC-Platform-, den Channel-, NLU/Interpreter-Service- sowie den Backend-Connector

Vielseitig einsetzbare KI-Assistenten:

Die KI-Assistenten können in verschiedenen Use-cases eingesetzt werden: Primär als Voice Assistant in den zentralen Hotlines, als Chat-Assistant in den verschiedenen digitalen Kanälen, als Knowledge-Assistants für die natürlich-sprachliche Suche nach Informationen in diversen Dokumentenformaten oder als Agent Assistants zur Unterstützung der CC-Agenten während des Gesprächs oder Chats