Der Konsens der Experten

Die Übereinstimmung ist bemerkenswert. Sam Altman spricht von „a couple of thousand days“ bis zur AGI, konkretisiert auf etwa 3.500 Tage. Demis Hassabis nennt 3–5 Jahre. Ein ehemaliger OpenAI-Entwickler glaubt sogar an nur zwei Jahre. Selbst Elon Musk, nicht gerade für Zurückhaltung bekannt, schätzt 3–6 Jahre.

Diese Einschätzungen mögen optimistisch klingen, doch die Daten sprechen eine deutliche Sprache. In der bisher größten Umfrage unter KI-Forschern schätzten über 2.700 Wissenschaftler gemeinsam, dass es eine 10-prozentige Wahrscheinlichkeit gibt, dass KI-Systeme bis 2027 Menschen in den meisten Aufgaben übertreffen können.

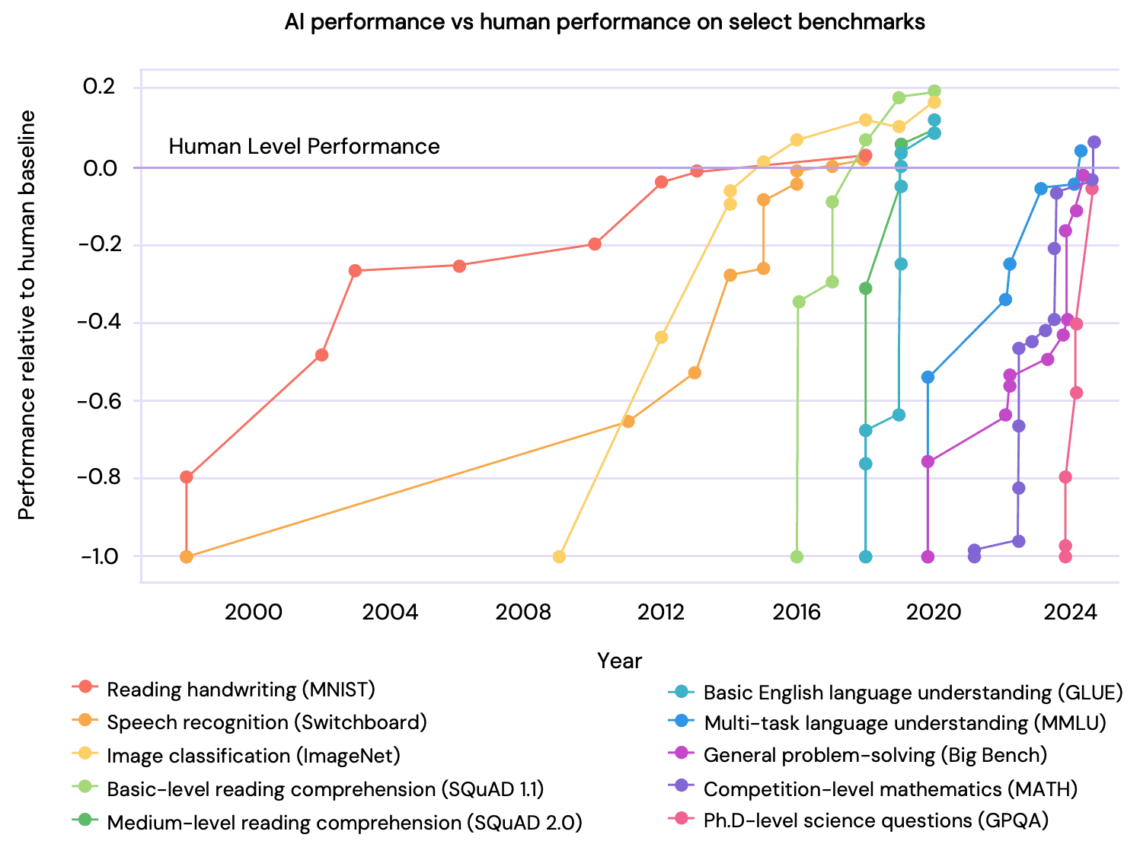

Die Leistungssteigerung ist messbar

Der International AI Safety Report 2025 unter Leitung von Yoshua Bengio zeigt eindrucksvoll, wie KI-Systeme in immer mehr Disziplinen die „Human Level Performance“ übersteigen. Die Entwicklungssprünge werden dabei immer kürzer. Was früher Jahrzehnte dauerte, geschieht nun in Jahren oder Monaten.

Besonders aufschlussreich: Die Fortschritte folgen einem vorhersagbaren Muster. Sobald ein Bereich digitalisiert und in Trainingsdaten umgewandelt werden kann, ist es nur eine Frage der Zeit und Rechenleistung, bis KI-Systeme menschliche Experten übertreffen.

Die Compute-Gleichung

Unser Paper analysiert die zentrale Rolle der Rechenleistung. Aktuelle Schätzungen gehen davon aus, dass menschliche Gehirne etwa 1.000-mal mehr Neuronen haben als heutige LLMs Neuronen-Äquivalente. Bei den Synapsen beträgt der Faktor etwa 100.

Für einen Faktor 1.000 mehr Rechenleistung kalkulieren die Autoren von „AI 2027“, dass bis 2027 einzelne Projekte hundert Millionen High-End-GPUs einsetzen könnten. Das klingt gewaltig, ist aber nicht unmöglich, wenn das exponentielle Compute-Wachstum anhält.

Die Energieanforderungen wären allerdings enorm: 70 Gigawatt, verglichen mit den 30 Watt unseres Gehirns. Das entspräche etwa einem halben Dutzend großer Kraftwerke. Hier zeigen sich physische und ökonomische Grenzen.

Die Datenfrage

Ein weiteres Limit könnte die Verfügbarkeit von Trainingsdaten sein. Das gesamte Internet wurde bereits für aktuelle LLMs genutzt. Weitere Datenquellen müssen erschlossen oder künstlich generiert werden.

Doch auch hier zeigt sich: Die Kreativität der Forscher kennt kaum Grenzen. Synthetische Daten, Simulationen und neue Datenquellen erweitern kontinuierlich den Trainingspool. Yann LeCun weist darauf hin, dass ein vierjähriges Kind etwa die gleiche Datenmenge visuell verarbeitet hat wie LLMs aus dem Internet ziehen. Der Raum für Expansion ist also noch gewaltig.

Investitionen ohne Vergleich

Die finanziellen Mittel fließen in noch nie dagewesenen Dimensionen. Das Stargate-Projekt allein plant 500 Milliarden Dollar über vier Jahre. Tech-Giganten investieren zweistellige Milliardenbeträge in Rechenzentren. Meta will 2025 zwischen 60 und 65 Milliarden Dollar ausgeben.

Diese Investitionen sind kein Hype, sondern kalkulierte Wetten auf eine absehbare technologische Revolution. Die Unternehmen sehen die Entwicklung als so sicher an, dass sie bereit sind, gewaltige Summen zu riskieren.

Die Architektur-Debatte

Eine offene Frage bleibt: Reicht die Skalierung bestehender Architekturen? Sam Altman ist überzeugt, dass OpenAI weiß, was es braucht. Demis Hassabis sieht eine 50-prozentige Chance, dass keine weiteren Durchbrüche wie die Transformer-Architektur nötig sind.

Yann LeCun widerspricht vehement. Für ihn sind heutige LLMs fundamental begrenzt. Doch selbst wenn neue Architekturen nötig wären, die Geschichte zeigt: Durchbrüche kommen oft schneller als erwartet. Vom Perceptron zum Transformer vergingen Jahrzehnte, doch die Entwicklung beschleunigt sich exponentiell.

Historische Parallelen

Unser Paper erinnert daran, dass technologische Prognosen oft zu konservativ waren. 2017 erschien Max Tegmarks „Leben 3.0“, in dem Experten AGI frühestens in 10–30 Jahren sahen, viele erst in 100 Jahren oder nie. Nur acht Jahre später sprechen dieselben Experten von 2–5 Jahren.

Die Verschiebung der Zeitperspektiven ist dramatisch: Was 2017 als „in diesem Jahrhundert“ galt, wird heute für die nächsten Jahre erwartet. Diese Beschleunigung folgt einem bekannten Muster technologischer Revolutionen.

Die kritischen Faktoren

Zusammengefasst identifiziert unsere Recherche drei Schlüsselfaktoren für die Timeline:

- Compute-Skalierung: Mit Moore’s Law und spezialisierten KI-Chips ist eine 1.000-fache Steigerung bis 2030 plausibel

- Datenverfügbarkeit: Neue Quellen und synthetische Daten erweitern kontinuierlich die Trainingsmöglichkeiten

- Algorithmus-Fortschritte: Selbst ohne revolutionäre Durchbrüche verbessern sich Architekturen stetig

Alle drei Faktoren entwickeln sich parallel und verstärken sich gegenseitig. Das macht die Timeline von 2027 nicht zur Gewissheit, aber zu einer realen Möglichkeit, auf die wir vorbereitet sein müssen.

Fazit: Die Zeit läuft

Die Analyse zeigt: Die genannten Zeiträume sind keine Science-Fiction. Sie basieren auf messbaren Trends, massiven Investitionen und dem Konsens führender Experten. Ob AGI nun 2027 oder 2030 kommt, ist fast nebensächlich. Entscheidend ist, dass wir uns jetzt auf diese Zukunft vorbereiten.

Die Frage ist nicht mehr, ob AGI kommt, sondern wie wir sicherstellen, dass sie zum Nutzen der Menschheit entwickelt wird. Die Zeit für diese Weichenstellungen läuft ab.

Bei SemanticEdge beobachten wir diese Entwicklungen genau. Als Pionier von Conversational AI kennen wir sowohl die Potenziale als auch die Risiken fortschrittlicher KI-Systeme. SemanticEdge steht für eine sichere und transparente Conversational AI über das Zusammenspiel der generativer KI mit einer zweiten ausdruckstarken regelbasierten Intelligenz, die das Risiko von Halluzinationen und Alignement Faking minimiert. Abonnieren Sie unseren Newsletter für weitere Analysen aus unserem Forschungspapier.